Переключение режима кеширования контролеров lsi на ходу

При мертвой батарее

megacli -LDSetProp CachedBadBBU -L0 -a0

вернуть обратно

megacli -LDSetProp NoCachedBadBBU -L0 -a0

Exchange, esx, AD, GPO, veeam, adaptec,lsi megaraid

При мертвой батарее

megacli -LDSetProp CachedBadBBU -L0 -a0

вернуть обратно

megacli -LDSetProp NoCachedBadBBU -L0 -a0

Для отключения автоматического бродкаста на интерфейсах

/routing ospf interface add interface=all passive=yes@echo OFF

net localgroup TerminalAdmins | find /i "%username%"

if %ERRORLEVEL% == 0 goto admin

logoff.exe

exit

:admin

start /B explorer.exe

exitТеперь при подключении пользователя по RDP скрипт проверит, входит ли пользователь в группу TerminalAdmins.

Если пользователь в группу не входит, он будет сразу же разлогинен.

Самый простой способ как запретить межгород для некоторых номеров

У многих записная книжка в телефоне забита в формате +7, а большинство Российских операторов ip телефонии этот формат не понимают и ждут номера начинающегося на 8.

Это инструкция как автоматически сделать подмену +7 на 8 в Elastix (Asterisk)

Для замены +7 на 8 в Elastix необходимо внести изменения в файл extensions_custom.conf. Для этого входим в панель управления Elastix, закладка PBX -> Tools, меню Asterisk File Editor. Листаем и находим необходимый нам файл extensions_custom.conf, и открываем его, нажав левой кнопкой мыши.

Находим в файле строку [from-internal-custom] и сразу после неё добавляем строку:

exten => _+7XXXXXXXXXX,1,GoTo(outbound-allroutes,8${EXTEN:2},1)

Нажимаем Save.

Изменения вступят в силу после перезагрузки Астериска. Самый простой способ перезагрузить Астериск закладка PBX -> Tools, меню Asterisk-Cli, в поле Command ввести reload и нажать кнопку Execute. Также можно с консоли или просто перезагрузить компьютер на котором установлен Астериск.

Если вы знаете как можно сделать подмену +7 на 8 через Trunk или Outbound Routes — подскажите. Вариант с «8+7|» или «8+.7|» не работают.

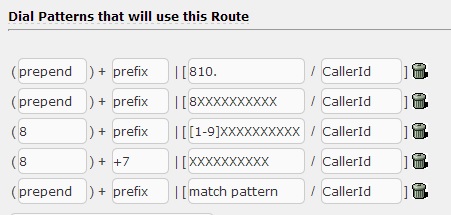

В последних версиях Elastix это легко делается для исходящих правил. В prepend пишем +7, а в prefix 8.

Думаю также можно поступить и указав в самом транке.

Вот пример из моего исходящего правила. Заменяем +7 на 8 и добавляем 8 где цифр в номере 10.

Делалось это для корректного отзвона. Просто один оператор у меня показывает номер как +7, а другой вообще без кода страны для Российских номеров.

Итак, как я и обещал, отписываюсь о возможности подмены.

Так как в моём случае нужно было убить сразу 2х зайцев, поэтому у меня и не выходил каменный цветок, а именно:

Есть sip-провайдер (по умолчанию он принимает номера, набранные через +7), нужно на него выход сделать через 9.

Соответственно делал так:

Например мне нужно звонить в город (Москва и мобильные — 11 значные номера), соответственно делал так: в оutbound routes создал роут: prepand (пусто) + prefix (9) | match patern (XXXXXXXXXXX) — здесь очень внимательным нужно быть к количеству иксов! Дело в том, что сначала я думал, что девятку тоже надо обозначать иксом или приписывать перед ними, но такая схема не работала, в итоге я понял, что иксов (или других спецсимволов) должно быть ровно столько, сколько в номере цифр!

Дальше, что касается подмены 8ки на 7ку:

Это я разрулил на сиповском транке вот таким образом prepand (7) + prefix (8) | match patern (.X)

Теперь у меня всё работает!

P.S. В случае, если должна быть обратная замена 7ки на 8ку, то соответственно: prepand (8) + prefix (7) | match patern (.X)

P.S. Если у вас не 7, а +7, то нужно пробовать как и +7 и как 007, потому что некоторые провайдеры и телефонные станции + расценивают как 2 нуля.

В логах mysql много ошибок подобного рода.

120920 9:25:28 [ERROR] /usr/sbin/mysqld: Table ’./old_sm/phones’ is marked as crashed and last (automatic?) repair failed

Поскольку автоматическое исправление не сработало, то будем исправлять вручную.

Перед любым таким действием настоятельно рекомендуется сделать резервное копирование данных.

Заходим в командную строку mysql.

Запускаем проверку таблицы.

mysql -u root -p stalker_db

mysql> check table phones;

+——————————-+—-+———+—————————————————————+

| Table | Op | Msg_type | Msg_text |

+——————————-+—-+———+—————————————————————+

| old_sm.phones | check | warning | Table is marked as crashed and last repair failed |

| old_sm.phones | check | error | Found 6833 keys of 3930951 |

| old_sm.phones | check | error | Corrupt |

+——————————-+—-+———+—————————————————————+

3 rows in set (0.37 sec)

Запускаю восстановление таблицы.

mysql> repair table phones;

+——————————-+——+———+————————————————————-+

| Table | Op | Msg_type | Msg_text |

+——————————-+——+———+————————————————————-+

| old_sm.phones | repair | error | Can’t create new tempfile: ’./old_sm/phones.TMD’ |

| old_sm.phones | repair | status | Operation failed |

+——————————-+——+———+————————————————————-+

2 rows in set (0.01 sec)

Т. е. при запущенном mysql-сервере восстановлению не подлежит. Останавливаю mysql

service mysql stop

Запускаю восстановление с помощью myisamchk. Данный метод будем работать с таблицами на движке MyISAM. Если у вас таблицы на движке InnoDB может помочь пересоздание таблицы с заливкой старых данных.

root@112-1:/var/lib/mysql/old_sm# myisamchk -r -f phones.MYI

— recovering (with sort) MyISAM-table ’phones.MYI’

Data records: 3930951

— Fixing index 1

— Fixing index 2

— Fixing index 3

— Fixing index 4

— Fixing index 5

Запускаю mysql сервер

service mysql start

Ошибка пропала, что и требовалось.

Послать USSD-команду (например, запрос баланса и другие управляющие команды) очень просто. Например, для отправки *923# с модема dongle0 нужно написать такую команду в консоли Asterisk:

pbx*CLI> <b>dongle ussd dongle0 *923#</b>

Добавляем Dilaplan:

[from-gsm]

exten => sms,1,Verbose(Incoming SMS from ${CALLERID(num)} ${SMS})

exten => sms,n,System(/usr/bin/php /etc/asterisk/sms.php ${STRFTIME(${EPOCH},,%Y-%m-%d %H:%M:%S)} — ${DATACARD} — ${CALLERID(num)}: ${SMS_BASE64})

exten => sms,n,Hangup()

exten => ussd,1,Verbose(Incoming USSD: ${USSD})

exten => ussd,n,System(/usr/bin/php /etc/asterisk/ussd.php ${STRFTIME(${EPOCH},,%Y-%m-%d %H:%M:%S)} — ${DATACARD}: ${USSD_BASE64})

exten => ussd,n,Hangup()

exten => s,1,Set(CALLERID(all)=${CALLERID(num)})

exten => s,n,Set(CALLERID(num)=8${CALLERID(num):2})

exten => s,n,goto(from-trunk,${DONGLEIMEI},1)

И два скрипта в систему

sms.php:

<?php

$sms=base64_decode($argv[6]);

//var_dump($argv);

$smsok=$argv[1].» «.$argv[2].» «.$argv[5].» «.$sms;

$smsok = str_replace(’«’, ’’, $smsok);

$smsok = str_replace(„’“, „„, $smsok);

$smsok = preg_replace („/[^а-яА-Я0-9a-zA-z\s\(\)\[\]\-\:\*\.\,\%\$\@\+\-\{\}\?\>\<\#\^\;\=\_\№]/u“,““,$smsok);

$cmd=»echo $smsok | mail -s ’Incoming SMS from $argv[5]’ admin@mail.ru«;

exec($cmd);

$cmd=»echo $smsok >> /var/log/asterisk/sms.txt«;

exec($cmd);

?>

и ussd.php:

<?php

$sms=base64_decode($argv[5]);

var_dump($argv);

$smsok=$argv[1].» «.$argv[2].» «.$sms;

$smsok = str_replace(’«’, ’’, $smsok);

$smsok = str_replace(„’“, „„, $smsok);

$smsok = preg_replace („/[^а-яА-Я0-9a-zA-z\s\(\)\[\]\-\:\*\.\,\%\$\@\+\-\{\}\?\>\<\#\^\;\=\_\№]/u“,““,$smsok);

$cmd=»echo $smsok | mail -s ’Incoming USSD’ admin@mail.ru«;

exec($cmd);

$cmd=»echo $smsok >> /var/log/asterisk/ussd.txt«;

exec($cmd);

?>

Добавляем автопроверку баланса и отправку на почту каждый день в 22-00:

crontab -e

00 22 * * * /usr/sbin/asterisk -rx «dongle ussd dongle0 *105#»

«Шепот» — это когда «Опытный сотрудник» подключается к диалогу «Клиент» — «Молодой сотрудник» и помогает молодому вести диалог. «Опытного», естественно, слышит только молодой — клиенту незачем знать об этом.

На удивление, гугломашина выдала направление «подумать» далеко не на первой ссылке. В сборке с вебмордой FreePBX данный механизм делается внедрением в файл extensions_override_freepbx.conf следующих строк:

[app-chanspy]

exten => 555,1,Macro(user-callerid)

exten => 555,2,Authenticate(1234)

exten => 555,3,Read(SPYNUM,agent-newlocation)

exten => 555,4,ChanSpy(SIP/${SPYNUM},wqv(-1))

;--== end of [app-chanspy] ==--;

Механизм подменяет собой штатный ChanSpy. Пользоваться просто: опытный набирает 555, вводит пароль (1234), вводит внутренний номер «молодого» и включается в разговор.

Исходная ситуация: на сетевом диске лежит архив backup.tgz размером >50GB, надо внутри найти некие файлы и скопировать на новый сервер. Распаковать все это не представляется возможным, какие файлы из архива необходимы тоже известно достаточно приблизительно. В таком случае лучше архив смонтировать как виртуальную файловую систему и работать уже с ней. Основная система Debian Lenny 5.0 (x64).

Во-первых, нам понадобится AVFS:

$ sudo apt-get update

$ sudo apt-get install avfsВо-вторых, просто заходим в нужный архив и работаем с ним как с любой файловой системой в режиме [read only].

$ cd /home/rat/.avfs/mnt/backup/server.domain.lv/backup.tgz#Внутри архива прекрасно работает find, любители могут воспользоваться Midnight Commander.

Вообще, AVFS поддерживает множество типов архивов, подключения по ftp. Есть возможность автоматически запускать AVFS в режиме демона (avfsd) при старте компьютера.

P.S. Если возникает проблема с fuse, например такая:

fuse: failed to open /dev/fuse: Permission deniedПроверьте, что ваш пользователь в группе fuse.

$ groups

rat adm dialout cdrom floppy audio video plugdevТогда делаем так:

$ sudo usermod -a -G fuse rat

$ groups

rat adm dialout cdrom floppy audio video fuse plugdev